L’ultima ondata di immagini generate dall’intelligenza artificiale in stile Studio Ghibli ha sollevato un acceso dibattito tra appassionati e addetti ai lavori. Su social e forum molti fan hanno protestato: “È un insulto all’arte”, sostengono in tanti di fronte a scene iconiche ricreate in pochi secondi da modelli come GPT-4o. Un video virale confronta un’animazione di 4 secondi tratta da Si alza il vento – a cui l’animatore Eiji Yamamori dedicò un anno e tre mesi di lavoro – con la rapidità sconcertante di un output automatizzato.

Questa “Ghiblificazione” memetica – dalla rilettura in chiave Ghibli de Il Signore degli Anelli fino a eventi di cronaca trasformati in cartoon – ha spinto alcuni a dichiarare che per quanto raffinata possa apparire la “spazzatura” prodotta da un algoritmo, essa non potrà mai replicare la “emozione, profondità, cuore e anima” visibili nell’opera di un artista umano. Lo stesso Hayao Miyazaki, notoriamente restio alle scorciatoie tecnologiche, già nel 2016 bollò una demo di animazione generata al computer come “un insulto alla vita stessa”, ribadendo che mai avrebbe integrato simili tecnologie nel proprio processo creativo.

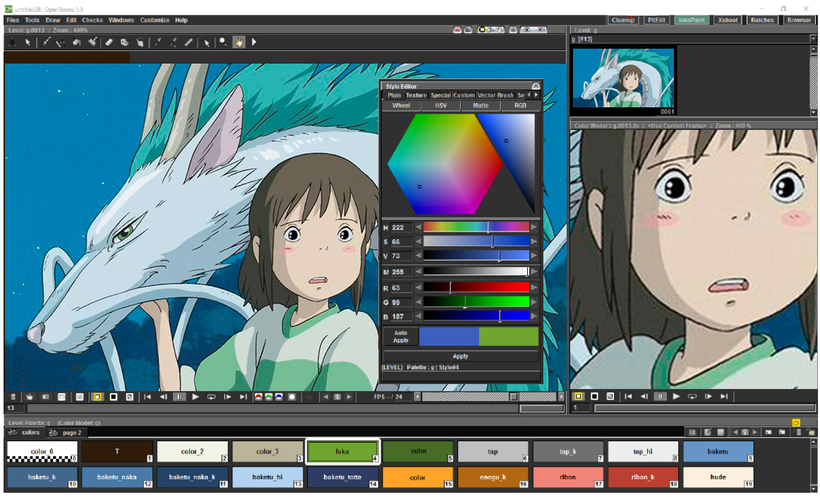

Eppure è ironico notare che proprio la tecnologia digitale – pur se in forme meno autonome – è da decenni parte integrante dell’eredità produttiva dello Studio Ghibli. Sin dalla metà degli anni ’90, il celebre studio giapponese ha sfruttato strumenti informatici per coniugare l’artigianalità del disegno a mano con le potenzialità del colore e della composizione digitale. In particolare, nel 1995 Ghibli adottò Toonz, un software di animazione 2D sviluppato in Italia, con l’obiettivo dichiarato di poter “combinare senza soluzione di continuità l’animazione disegnata a mano con la colorazione digitale”.

La prima applicazione concreta avvenne durante la produzione di Principessa Mononoke (1997), il film di Miyazaki ricordato anche per essere il primo suo lavoro a incorporare elementi di computer grafica. Da allora in poi quasi tutti i lungometraggi dello studio hanno fatto uso di Toonz – in una versione sempre più personalizzata nota come Toonz Ghibli Edition – per fasi chiave come il digi-paint, il color design e il compositing dei disegni su livelli di animazione.

Un caso emblematico è I miei vicini Yamada (1999) di Isao Takahata, il primo film Ghibli realizzato interamente in digitale (senza ricorrere alle tradizionali celle di acetato). Per ricreare lo stile acquerellato dei disegni, il team sostituì la pittura manuale su rodovetro con la colorazione al computer, programmando addirittura effetti che introducessero imperfezioni e irregolarità tipiche dell’acquerello per conservare il feeling artigianale.

Se questo esperimento entusiasmò parte della critica, suscitò anche attriti interni – Miyazaki, da purista, era convinto che la CGI andasse usata solo se indispensabile e resa del tutto “invisibile” allo spettatore. Nondimeno, il percorso era tracciato: negli anni 2000 Ghibli ha continuato a integrare software di grafica nei propri film, mantenendo però un approccio calibrato.

Opere acclamate come La città incantata (2001), Il castello errante di Howl (2004), Ponyo (2008) o Arrietty (2010) sono state animate con il consueto lavoro manuale di disegno ma rifinite attraverso l’uso sistematico di Toonz per colorare digitalmente ogni fotogramma e combinare effetti speciali e fondali dipinti. Persino il delicato stile “a pastello” de La storia della principessa Kaguya (2013) – che a occhi ingenui potrebbe sembrare totalmente analogico – fu supportato dallo stesso software, così come Si alza il vento (2013) e altre produzioni dello studio.

In effetti, dopo Arrietty, lo studio arrivò a modificare in house il programma per adattarlo ancor meglio al proprio workflow, segno di quanto la tecnologia fosse divenuta parte del DNA creativo ghibliano. Culmine di questo percorso è stata la decisione, nel 2016, di rilasciare pubblicamente il software sotto forma di open source con il nome OpenToonz. Grazie a una partnership con una società giapponese, la versione personalizzata da Ghibli di Toonz è stata resa disponibile gratuitamente alla comunità globale di animatori, con tanto di codice sorgente aperto: un evento epocale che ha evidenziato la volontà di condividere gli strumenti digitali che avevano contribuito alla magia visiva dello studio.

Vale la pena chiedersi, dunque, che rapporto c’è – o potrebbe esserci – tra OpenToonz e le moderne AI generative. OpenToonz di per sé è un software votato all’animazione “classica” assistita dal computer (dalla scannerizzazione dei disegni alla colorazione vettoriale), e non incorpora nativamente algoritmi di deep learning generativi. Tuttavia, la sua natura aperta e modulare ha già favorito alcune sperimentazioni: ad esempio, è disponibile un plugin denominato Neural Style che utilizza una rete neurale per applicare lo stile visivo di un’immagine su un’altra, un chiaro precursore dell’odierno style transfer. Si tratta di funzioni pionieristiche sviluppate dalla comunità e integrate tramite il sistema di effetti di OpenToonz – un segnale che l’ecosistema del software è stato tra i primi ad esplorare applicazioni di machine learning nell’animazione tradizionale.

Oggi le possibilità di integrare vere e proprie AI generative open source in OpenToonz sono ancora più concrete. Da un lato, esistono modelli di diffusione e reti neurali pubblicamente disponibili capaci di generare o modificare immagini con un semplice input testuale; dall’altro, OpenToonz essendo open source può essere esteso con script e plugin personalizzati – persino scritti in Python – così da mettere questi modelli al servizio dell’animatore.

In linea teorica, nulla vieta di usare un modello generativo per creare bozzetti di background in stile Ghibli da importare in OpenToonz come livello da rifinire manualmente, oppure di sfruttare algoritmi di inbetweening che calcolino automaticamente i disegni intermedi tra due pose chiave disegnate dall’artista, accelerando il lavoro senza stravolgerne lo stile.

Un esempio particolarmente illuminante di come la poetica Ghibli possa incontrare il mondo digitale senza snaturarsi è Ni no Kuni: La minaccia della Strega Cinerea, videogioco sviluppato da Level-5 in stretta collaborazione con lo studio. Pubblicato originariamente tra il 2010 e il 2011, questo progetto non fu una semplice ispirazione estetica: fu una vera alleanza creativa. Il team di Ghibli realizzò a mano una vasta quantità di tavole concettuali, sequenze animate e studi di personaggi, infondendo al gioco l’incanto visivo tipico dei suoi film. Ogni animazione tradizionale venne successivamente trasformata in modelli tridimensionali dai grafici di Level-5, con una dedizione quasi ossessiva nel conservare la morbidezza delle linee e la ricchezza espressiva originaria.

Ciò che rende Ni no Kuni particolarmente affascinante, nel contesto di questa riflessione, è proprio la trasparenza del processo: la transizione dalla matita alla modellazione digitale non avvenne per sostituire la sensibilità dell’artista, ma per amplificarla, trasportando il mondo disegnato nel linguaggio interattivo del videogioco. Ogni ambientazione, ogni creatura del titolo conserva la grammatica visiva di Ghibli, tanto che muoversi nei suoi scenari restituisce la stessa sensazione di meraviglia che si prova dinanzi a un fondale dipinto a mano.

Eppure, il lavoro manuale non venne mai sacrificato sull’altare della velocità di produzione. Le cutscene animate restano uno dei capolavori del progetto, realizzate internamente dallo Studio Ghibli con la consueta attenzione artigianale, mentre le sequenze di gioco furono sviluppate con un uso mirato del cel-shading, proprio per mantenere quella patina di magia illustrata. La colonna sonora, affidata a Joe Hisaishi, contribuì ulteriormente a cementare l’identità estetica e emotiva del titolo, rendendo l’esperienza sonora inseparabile da quella visiva.

Ni no Kuni dimostra come la tecnologia, se orchestrata con rispetto e visione, possa servire l’arte anziché impoverirla. Non si trattava di replicare lo stile Ghibli per mera fascinazione commerciale, ma di esplorare nuove modalità narrative capaci di ampliare le frontiere del racconto visivo. Nel gioco, la mano umana e il digitale si fondono in un equilibrio maturo: un laboratorio virtuoso che testimonia come anche l’eredità più squisitamente artigianale possa trovare nuovi respiri nel linguaggio dei pixel.

Alla luce di questa esperienza, è difficile liquidare il dialogo tra intelligenza artificiale e animazione come un vicolo cieco. Al contrario, Ni no Kuni suggerisce che ogni strumento, anche il più avanzato, può diventare estensione del pensiero umano se guidato da sensibilità autentica. Non è la tecnologia in sé a svuotare l’arte, ma l’intenzione con cui la si impiega. Quando il fine resta la bellezza, la meraviglia, la narrazione viva, allora anche una fredda macchina può partecipare — umilmente — alla creazione della magia.

Proviamo adesso un piccolo esperimento: mettiamo a confronto un fotogramma tratto dal videogioco Ni no Kuni (nella versione remastered) con una sua reinterpretazione generata da GPT-4o. La prima mostra l’immagine originale, il risultato di un motore grafico 3D che produce sessanta fotogrammi al secondo in modo automatico, senza intervento manuale, con tutta la precisione meccanica della sua programmazione. Dopo, invece, lo stesso istante viene trasformato dall’intelligenza artificiale, che rielabora la scena come se fosse una tavola disegnata a mano, cercando di restituire quella qualità artigianale che si avverte nei bozzetti preparatori dello Studio Ghibli, da cui gli artisti 3D del gioco hanno tratto ispirazione.

Viene naturale chiedersi: quale delle due immagini trasmette un’emozione più profonda? Quella fedele al rendering digitale del motore di gioco, o la versione rigenerata dall’intelligenza artificiale, che prova a restituire la vitalità e la delicatezza di un disegno umano?

Diversi studi recenti mostrano che l’AI può automatizzare compiti ripetitivi nell’animazione – dal riempimento di colori secondo lo schema voluto, fino alla generazione di intervalli fluidi tra fotogrammi – permettendo agli autori di concentrarsi maggiormente sugli aspetti creativi ed espressivi. Tutto questo non significa affatto rimpiazzare la mano umana, bensì dotarla di nuovi attrezzi: esattamente come negli anni ’90 l’adozione del digitale in Ghibli non tolse valore ai disegni di matita, ma li valorizzò con colori lucenti e composizioni impeccabili, oggi l’AI potrebbe – se ben integrata – alleggerire ulteriormente la fatica tecnica, lasciando intatta la visione artistica.

È comprensibile che vedere un algoritmo replicare lo stile Ghibli in un lampo provochi sconcerto e indignazione, specie in chi conosce la dedizione quasi sacra con cui ogni frame veniva creato dallo studio. Le critiche odierne riecheggiano in parte i timori di ieri: quando Takahata sperimentò la pittura digitale, molti puristi storsero il naso, e lo stesso Miyazaki giudicò severamente l’uso esibito del computer in Yamada.

Col tempo, però, la comunità ha accettato che dietro la poesia di Spirited Away o Howl c’era anche il lavoro invisibile di software e tecnici, senza per questo diminuire la meraviglia provata sullo schermo. Allo stesso modo, l’AI art non va demonizzata a priori, ma capita nelle sue potenzialità e limiti: una singola immagine generata da GPT-4 potrà anche emulare l’estetica di uno sketch Ghibli, ma non contiene di per sé una narrazione, né la cura meticolosa che traspare in un film dello studio.

D’altro canto, se quelle stesse tecnologie fossero poste al servizio di artisti e animatori – magari all’interno di strumenti open source come OpenToonz, in cui l’output dell’AI diventa materia prima da plasmare con intervento umano – allora si potrebbe davvero parlare di evoluzione e non di semplice imitazione.

Del resto, Studio Ghibli ha sempre fatto della fusione tra tradizione e innovazione un proprio marchio di fabbrica: il nome stesso “Ghibli”, ispirato a un veloce aereo italiano, evocava l’idea di un vento nuovo nell’animazione. È dunque coerente con questa eredità vedere la tecnologia digitale, inclusa l’intelligenza artificiale, non come una minaccia esterna, ma come un altro vento – potente ma da saper governare – che può spingere più lontano la creatività.

In risposta alle recenti polemiche, alcuni sviluppatori hanno adottato un approccio cauto, limitando l’uso esplicito dello stile Ghibli nei generatori di immagini. Segno che le sensibilità degli artisti vengono prese in seria considerazione. Tuttavia, la vera sfida consisterà nel trovare un equilibrio: proteggere l’unicità dell’arte (e i diritti ad essa collegati) senza frenare le possibilità offerte dai nuovi strumenti.

La storia produttiva dello Studio Ghibli insegna che l’innovazione tecnologica può convivere con l’artigianato artistico: ieri erano le palette digitali e i software di compositing, domani potrebbero essere algoritmi intelligenti e modelli generativi. Ciò che conta è che alla guida resti sempre l’occhio e la mano del creatore umano, capace di infondere quell’anima che nemmeno il più sofisticato calcolatore può simulare davvero.

In definitiva, invece di vedere le immagini AI “alla Ghibli” come una profanazione, possiamo leggerle come il segnale di quanto l’arte dello studio abbia influenzato l’immaginario globale – al punto che perfino le macchine cercano di imitarla. E ricordando che quelle stesse macchine, opportunamente domate, hanno già contribuito a fare grande il cinema di Ghibli, possiamo affrontare il futuro dell’animazione con uno sguardo meno allarmato e più curioso, fedeli allo spirito pionieristico di chi seppe unire matita e silicio in un’unica visione poetica.